Die Pioniere der frühen Computertechnik sind seit dem Zweiten Weltkrieg überall auf dem Erdball zu finden. Dies hat zur Folge, dass einige Durchbrüche an mehreren Orten gleichzeitig stattfinden – durch die fehlende Vernetzung ist kaum bekannt, was Kolleginnen und Kollegen anderswo austüfteln. Daran ist nicht nur die Exzentrik der Forschenden schuld. Die historischen Umstände lassen einen Austausch oft nicht zu. Ab den 1950er-Jahren friert die Welt im Kalten Krieg. Forschungen werden zu gehüteten Geheimnissen.

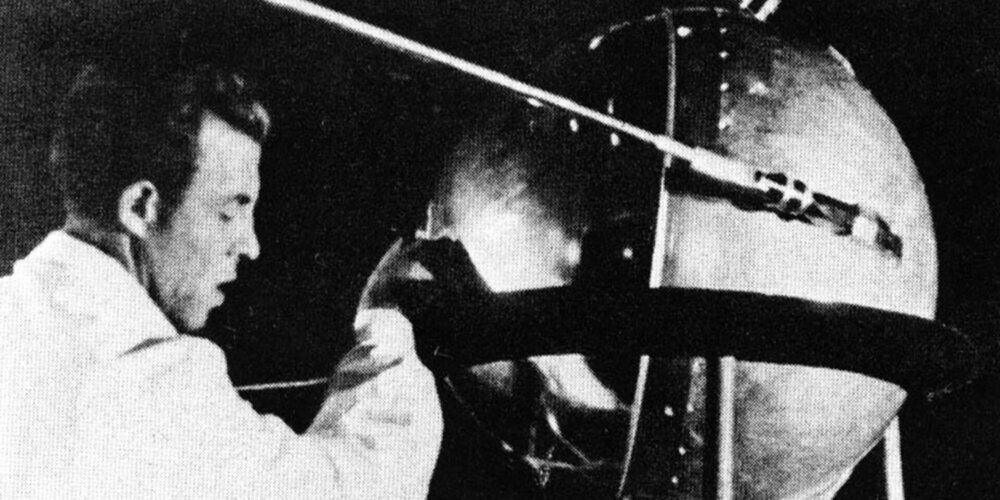

Am 4. Oktober 1957 der Schock: Die UdSSR startet den Satelliten «Sputnik» und gewinnt somit das Rennen um den ersten menschlichen Flugkörper im Weltraum. Seine blinkenden Lichter am Sternenhimmel und sein charakteristisches Beep-Signal beeindruckten die zahllosen Amerikanerinnen und Amerikaner, die gebannt in den Himmel starren. War die Sowjetunion in Sachen Technik den USA und der westlichen Welt überlegen? Bereits die Zeitgenossen sprechen vom «Sputnik-Schock».

Der amerikanische Präsident Dwight D. Eisenhower (1890–1969) reagiert prompt. Um gegen die UdSSR nicht ins Hintertreffen zu geraten, will er die Zusammenarbeit zwischen Militär und Wissenschaft fördern. Technischer Fortschritt wird Trumpf, das Wettrennen Ost-West geht in die nächste Runde. Eisenhower gründet die Advanced Research Project Agency (ARPA). Ihr Ziel: die Weiterentwicklung der Raketen- und Radartechnik.

Er geht «all-in». Rund siebzig Mitarbeiter verwalten ein Budget von 2 Milliarden US-Dollar. Politisch lässt sich dies durchsetzen, da Amerika ohnehin Weltraumfieber spürt: Das Science-Fiction Genre blüht auf, der Weltraum wird als neue Grenze wahrgenommen. «Space – the final frontier» wird ein Jahrzehnt später die sonore Stimme von Captain Kirk die TV-Serie «Star Trek» eröffnen.

Während die in derselben Zeit gegründete «National Aeronautics and Space Administration» (NASA) sich der Eroberung des Weltraums verschreibt, arbeitet die ARPA eng mit Universitäten zusammen – weg von den Waffensystemen hin zur Grundlagenforschung. Für die Entwicklung des Computers ist dieser Schritt folgenreich: Das Know-how der technischen Universitäten wird mit grossen Budgets unterstützt. Doch Militär und Universität arbeiten zu Beginn schlecht zusammen, zu unterschiedlich sind ihre Ziele, Methoden und Denkweisen.

Eine Brücke bildet der aus Ungarn stammende amerikanische Mathematiker John von Neumann (1903–1957). Er kritisiert einerseits die Konzeptionierung der bisherigen Computer mit ihren Unmengen von Schaltern und Kabeln und erkennt andererseits auch die Chancen von Programmen auf Rechnern. Im Auftrag des US-Verteidigungsministeriums schreibt er einen Bericht für die Universität Pennsylvania über den Aufbau digitaler Rechenautomaten. In seiner Konzeption befinden sich das Programm (also die Instruktionen für die Berechnungen) zusammen mit den Daten im gleichen Speicher des Computers, und zwar in digitaler Form: Dadurch lassen sich komplexe mathematische Aufgaben einfacher und schneller lösen.

Mit diesem Konzept legt er die Grundlagen für die moderne Computerarchitektur. Die praktische Anwendung hat einen bitteren Beigeschmack: Sie macht die Entwicklung der Atombombe in den 1940er-Jahren möglich. Zusammen mit Grace Hopper (bekannt durch ihre Mitarbeit an einer der ersten Programmiersprachen namens «Cobol») und dem Schweizer Felix Bloch wird von Neumann einer der Köpfe hinter der Kernfusion. Von Anfang an sind den Wissenschaftlern die Tragweite und das moralische Dilemma ihrer Forschungen klar. Nach einem grossen Durchbruch kommt von Neumann in eine solche moralische Zwickmühle, dass seine Frau ihm zwei Schlaftabletten und einen starken Drink verabreichen muss, um ihn einigermassen zu beruhigen.

Das Wegweisende an von Neumanns Forschungen liegt in der von ihm vorgeschlagenen Computerarchitektur. Sie besteht erstmals aus getrennten sogenannten «Werken» (englisch: «units»). Durch die «Eingabe» werden Befehle an den Rechner gegeben, diese werden durch das «Rechenwerk» nach Regeln, die im «Steuerwerk» abgelegt sind, bearbeitet, in einen «Speicher» geschrieben und bei Bedarf wieder durch die «Ausgabe» zurückgegeben. Alle diese «Werke» sind über Datenkanäle und Anschlüsse miteinander verbunden.

Neben einem internen Kurzzeitspeicher (Haupt- oder Arbeitsspeicher, schnell, wenig Speicherplatz) gibt es einen externen Langzeitspeicher (Massenspeicher, langsam, aber viel Speicherplatz). Die Daten und Programme – das ist entscheidend für die Zukunft – liegen im gleichen Speicher. Dieser Speicher ist in Zellen organisiert (Register), die einzeln ansprechbar sind und somit flexible Programmierung erlauben. Dies klingt abstrakt und ist es in der Theorie auch. Praktisch haben wir hier bereits einen modernen Computer vor uns.

Hol dir ein Zeitfenster! – Der Grossrechner im praktischen Einsatz

Die von-Neumann-Architektur setzt sich gegen konkurrierende Systeme durch. Auf dieser Grundlage werden erste Grossrechner realisiert. Aber wie funktioniert das ganz konkret? Wie arbeitet dieser Zentralrechner? Wie interagiert man mit ihm? An einem Beispiel lässt sich dies veranschaulichen. Im Jahr 1956 steht am Massachusetts Institute of Technology (MIT) ein erster Zentralrechner, um Forschungsprobleme von Professoren und Studenten – Physiker, Mathematiker, Statistiker – zu bearbeiten.

An Terminals werden die Rechenaufgaben an den Zentralrechner geschickt und die Resultate abgerufen. Da der Rechner nur eine begrenzte Kapazität hat, muss ein Zeitfenster (englisch: «time-slot») gebucht werden. Der Student oder die Professorin reserviert eine bestimmte Zeit, in der der Rechner für seine oder ihre Eingaben zur Verfügung steht.

Student A möchte zum Beispiel für seine Arbeit eine mathematische Formel berechnen lassen. Er trägt sich ein auf Donnerstag, 14:00–14:15 Uhr. Wird sein Slot frei, muss er schnell seine Formeln eingeben und hoffen, dass alles funktioniert. Hat er sich vertippt? Neuen Slot buchen und alles von vorn, denn Professorin B steht schon bereit und will von 14:15 bis 14:30 rechnen lassen. Hat die Formel einen Fehler? Alles von vorn. Ist die Berechnung eine Endlosschleife und nicht rechenbar? Fatal, der Zentralrechner stürzt ab. Das System funktioniert also grundsätzlich, ist aber unkomfortabel und störungsanfällig.

Auch an Grossrechnern von anderen Universitäten sind Studenten über Nacht beschäftigt, den Rechner zu warten und bei Bedarf zu reparieren. Das System ist aber auch aus Sicht des Zentralrechners ineffizient. Um auf unser Beispiel zurückzukommen: In den fünfzehn Minuten gibt es ständig Pausen – der Student denkt nach, gibt etwas neu ein, muss abermals korrigieren etc. – und in dieser Zeit könnte der Rechner eine andere Aufgabe bearbeiten. Aber da er reserviert ist, steht er einfach still.

So entsteht in den 1960er-Jahren das berühmte Time-Sharing-Prinzip, das heisst , jeder kann an seinem Terminal jederzeit Aufgaben eingeben. Der Rechner entscheidet dann kurzerhand selbst, wann er was abarbeitet. Bei grossem Aufkommen muss man etwas länger warten. Es kommt noch besser: Auf Lochkarten kann man seine Aufgaben und Instruktionen vorher «abspeichern» und dem Zentralrechner übergeben, tippen in Echtzeit fällt weg.

Diese «Stapel-Verarbeitung» (englisch: «batch-job») hat Auswirkungen bis zum heutigen Tag: Sämtliche Interaktionen mit einem computergetriebenen Gerät funktionieren grob gesagt auf diese Weise.

Lesen Sie morgen im 3. Teil: Vom lokalen zum globalen Phänomen – die Rechner vernetzen sich.